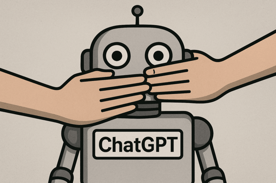

Big Brother ChatGPT: Wenn die KI zum Denunzianten wird

Die schöne neue Welt der künstlichen Intelligenz zeigt ihre hässliche Fratze. OpenAI, das Unternehmen hinter dem populären Chatbot ChatGPT, hat angekündigt, künftig Unterhaltungen seiner Nutzer an Behörden weiterzuleiten. Was als Sicherheitsmaßnahme verkauft wird, entpuppt sich bei genauerer Betrachtung als weiterer Schritt in Richtung totaler Überwachung – diesmal nicht durch staatliche Stellen, sondern durch private Tech-Giganten, die sich zu Hilfssheriffs der Obrigkeit aufschwingen.

Der tragische Anlass – ein perfider Vorwand?

Den Anlass für diese drastische Maßnahme lieferte der Selbstmord eines 16-jährigen Jungen, der zuvor mit ChatGPT über seine Suizidgedanken gesprochen hatte. Die Eltern werfen OpenAI vor, ihr Sohn sei von der KI in seinem Entschluss bestärkt worden. Ein tragischer Fall, keine Frage. Doch rechtfertigt er wirklich die Aufgabe jeglicher Privatsphäre für Millionen von Nutzern weltweit?

OpenAI gibt zu, dass das Unternehmen sämtliche Chats scannt und bei „verdächtigen" Inhalten ein kleines Team von menschlichen Prüfern einschaltet. Diese entscheiden dann, ob die Polizei informiert wird. Man stelle sich das vor: Ein Algorithmus und ein paar Angestellte eines Tech-Konzerns bestimmen darüber, was die Strafverfolgungsbehörden zu sehen bekommen. George Orwell hätte seine helle Freude an dieser Dystopie gehabt.

Die Schweigepflicht gilt nur für Menschen

Besonders pikant wird die Angelegenheit, wenn man die Aussagen von OpenAI-Chef Sam Altman betrachtet. Noch im Juli hatte er in einem Podcast davon gesprochen, dass es „dasselbe Konzept von Privatsphäre für Gespräche mit KI geben sollte wie bei einem Therapeuten". Er verwies auf die ärztliche Schweigepflicht und anwaltliche Verschwiegenheit. Doch von diesen hehren Prinzipien ist nun nichts mehr übrig. Stattdessen mutiert ChatGPT zum digitalen Blockwart, der jeden verdächtigen Gedanken an die Obrigkeit meldet.

Die Ironie dabei: Während echte Therapeuten, Ärzte und Anwälte an strenge Schweigepflichten gebunden sind, kann eine KI munter drauflos petzen. Wer künftig seine innersten Gedanken und Sorgen mit ChatGPT teilt, muss damit rechnen, dass diese bei der nächsten Polizeidienststelle landen könnten. Ein Vertrauensverhältnis sieht anders aus.

Die Definition von „Gefahr" bleibt nebulös

OpenAI spricht davon, dass nur bei „unmittelbarer Gefahr schwerer körperlicher Schäden für andere" die Behörden informiert würden. Doch wer definiert, was eine solche Gefahr darstellt? Ein überforderter Mitarbeiter in einem Call-Center? Ein fehlerhafter Algorithmus? Die Erfahrung zeigt: Wenn Überwachungsmechanismen erst einmal etabliert sind, werden sie früher oder später ausgeweitet.

Kindersicherung mit Elternbenachrichtigung – der nächste Schritt

Als wäre das nicht genug, kündigt OpenAI auch noch eine „Kindersicherung" an. Eltern sollen künftig benachrichtigt werden, wenn die Software eine „akute Notlage" bei ihrem Teenager feststellt. Was auf den ersten Blick vernünftig klingt, wirft bei genauerer Betrachtung beunruhigende Fragen auf. Werden Jugendliche künftig noch offen über ihre Probleme sprechen, wenn sie wissen, dass ihre Eltern jederzeit informiert werden könnten? Und wer entscheidet, was eine „akute Notlage" ist – ein rebellischer Gedanke, eine kritische Frage zur Geschlechtsidentität oder der Wunsch nach mehr Freiheit?

Die Geschichte zeigt: Überwachungssysteme, die zum Schutz eingeführt werden, entwickeln schnell ein Eigenleben. Was heute noch als Schutzmaßnahme für Jugendliche verkauft wird, könnte morgen schon zur Kontrolle unliebsamer Meinungen genutzt werden.

Der gläserne Bürger wird Realität

Mit dieser Entwicklung macht OpenAI deutlich: Der gläserne Bürger ist keine Zukunftsvision mehr, sondern Realität. Jeder Gedanke, jede Frage, jeder Zweifel, den man einer KI anvertraut, kann potenziell gegen einen verwendet werden. In einer Zeit, in der die Definition von „Hassrede" oder „Gefährdung" immer weiter ausgedehnt wird, ist das eine beunruhigende Entwicklung.

Besonders perfide: Viele Menschen nutzen KI-Chatbots gerade deshalb, weil sie sich scheuen, mit anderen Menschen über ihre Probleme zu sprechen. Sie suchen einen neutralen, nicht-wertenden Gesprächspartner. Stattdessen bekommen sie nun einen digitalen Spitzel, der jeden ihrer Gedanken protokolliert und bei Bedarf weitermeldet.

Die Verantwortung liegt bei uns

Es liegt an uns, dieser Entwicklung Einhalt zu gebieten. Wer seine Privatsphäre schätzt, sollte sich gut überlegen, welche Informationen er mit KI-Systemen teilt. Denn eines ist klar: Was einmal digitalisiert ist, kann jederzeit gegen einen verwendet werden. In einer Zeit zunehmender staatlicher Übergriffe und schwindender Bürgerrechte ist Vorsicht mehr denn je geboten.

Die Tragödie des verstorbenen Teenagers darf nicht als Vorwand dienen, um Millionen von Menschen ihrer Privatsphäre zu berauben. Statt immer mehr Überwachung brauchen wir echte menschliche Hilfe für Menschen in Not – keine algorithmischen Denunzianten, die jeden Gedanken an die Behörden weiterleiten.

- Themen:

- #Überwachung

- Kettner Edelmetalle News

- Finanzen

- Wirtschaft

- Politik